«统计学完全教程»笔记:第3章 期望

期望和方差

随机变量的期望

期望值(expected value),或均值(mean),或第一矩(first moment)1 定义为:

$$ \mathbb{E}(X)=\int x d F(x)= \begin{cases}\sum_{x} x f(x) & \text { if } X \text { is discrete } \\ \int x f(x) \mathrm{d}x & \text { if } X \text { is continuous }\end{cases} $$其中:

-

$f(x)$ 是概率密度函数

-

积分范围是 $x$ 的域

$k^{\text{th}}$ moment 定义为 $\mathbb{E}(X^k)$ 假定 $\mathbb{E}(|X|^k) < \infty $

定理:第 k 矩存在,则第 j ($\forall j, j < k$ ) 矩存在

$k^{\text{th}}$ central moment 定义为 $\mathbb{E}((X - \mu )^k) = \int_{-\infty }^{+ \infty }(x - \mu )^k f(x) \mathrm{d}x$

假设_总和_或_积分_是定义良好的,则可以简单记作:

$$ \mathbb{E}(X)=\mathbb{E} X=\int x d F(x)=\mu=\mu_{X} $$Lazy Statistician 法则:

$$ \mathbb{E}(Y)=\mathbb{E}(r(X))=\int r(x) d F_{X}(x) $$期望的性质

在任何情况成立:

$$ \mathbb{E}\left(\sum_{i} a_{i} X_{i}\right)=\sum_{i} a_{i} \mathbb{E}\left(X_{i}\right) $$在 $X_i$ 之间独立的前提下成立:

$$ \mathbb{E}\left(\prod_{i=1}^{n} X_{i}\right)=\prod_{i} \mathbb{E}\left(X_{i}\right) $$方差与协方差

方差用于度量分布的分散程度。

Let $X$ be a random variable with mean $\mu$. The variance of $X$ – denoted by $\sigma^2$ or $\sigma_X^2$ or $\mathbb{V}(X)$ or $\mathbb{V}X$ – is defined by

$$ \sigma^2 = \mathbb{E}(X - \mu)^2 = \int (x - \mu)^2\; dF(x) $$assuming this expectation exists. The standard deviation is $\text{sd}(X) = \sqrt{\mathbb{V}(X)}$ and is also denoted by $\sigma$ and $\sigma_X$.

Theorem 4.14. Assuming the variance is well defined, it has the following properties:

$\mathbb{V}(X) = \mathbb{E}(X^2) - \mathbb{E}(X)^2$ 2

If $a$ and $b$ are constants then $\mathbb{V}(aX + b) = a^2 \mathbb{V}(X)$

If $X_1, \dots, X_n$ are independent and $a_1, \dots, a_n$ are constants then

样本均值:$\overline{X}_n = \frac{1}{n} \sum_{i=1}^n X_i$

样本方差:$S_n^2 = \frac{1}{n - 1} \sum_{i=1}^n \left(X_i - \overline{X}_n\right)^2$

Theorem 4.16. Let $X_1, \dots, X_n$ be IID and let $\mu = \mathbb{E}(X_i)$, $\sigma^2 = \mathbb{V}(X_i)$. Then

$$ \mathbb{E}\left(\overline{X}_n\right) = \mu, \quad \mathbb{V}\left(\overline{X}_n\right) = \frac{\sigma^2}{n}, \quad \text{and} \quad \mathbb{E}\left(S_n^2\right) = \sigma^2 $$相关性(范围限定 $[-1,1]$ ):

$$ \rho = \rho_{X, Y} = \rho(X, Y) = \frac{\text{Cov}(X, Y)}{\sigma_X \sigma_Y} $$协方差满足:$\text{Cov}(X, Y) = \mathbb{E}(XY) - \mathbb{E}(X) \mathbb{E}(Y)$

协方差的性质:

$$ \mathbb{V}(X + Y) = \mathbb{V}(X) + \mathbb{V}(Y) + 2 \text{Cov}(X, Y) \quad \\ \text{ and } \quad \mathbb{V}(X - Y) = \mathbb{V}(X) + \mathbb{V}(Y) - 2 \text{Cov}(X, Y) $$更一般地:

$$ \mathbb{V}\left( \sum_i a_i X_i \right) = \sum_i a_i^2 \mathbb{V}(X_i) + 2 \sum \sum_{i < j} a_i a_j \text{Cov}(X_i, X_j) $$矩生成函数

详见 什么是矩生成函数?

重要随机变量的期望和方差

$$ \begin{array}{lll} \text{Distribution} & \text{Mean} & \text{Variance} \\ \hline \text{Point mass at } p & a & 0 \\ \text{Bernoulli}(p) & p & p(1-p) \\ \text{Binomial}(n, p) & np & np(1-p) \\ \text{Geometric}(p) & 1/p & (1 - p)/p^2 \\ \text{Poisson}(\lambda) & \lambda & \lambda \\ \text{Uniform}(a, b) & (a + b) / 2 & (b - a)^2 / 12 \\ \text{Normal}(\mu, \sigma^2) & \mu & \sigma^2 \\ \text{Exponential}(\beta) & \beta & \beta^2 \\ \text{Gamma}(\alpha, \beta) & \alpha \beta & \alpha \beta^2 \\ \text{Beta}(\alpha, \beta) & \alpha / (\alpha + \beta) & \alpha \beta / ((\alpha + \beta)^2 (\alpha + \beta + 1)) \\ t_\nu & 0 \text{ (if } \nu > 1 \text{)} & \nu / (\nu - 2) \text{ (if } \nu > 2 \text{)} \\ \chi^2_p & p & 2p \\ \text{Multinomial}(n, p) & np & \text{see below} \\ \text{Multivariate Nornal}(\mu, \Sigma) & \mu & \Sigma \\ \end{array} $$MGF

$$ \begin{equation} \begin{array}{ll}\text { Distribution } & \mathrm{MGF} \psi(t) \\ \hline \operatorname{Bernoulli}(p) & p e^{t}+(1-p) \\ \operatorname{Binomial}(n, p) & \left(p e^{t}+(1-p)\right)^{n} \\ \operatorname{Poisson}(\lambda) & e^{\lambda\left(e^{t}-1\right)} \\ \operatorname{Normal}(\mu, \sigma) & \exp \left\{\mu t+\dfrac{\sigma^{2} t^{2}}{2}\right\} \\ \operatorname{Gamma}(\alpha, \beta) & \left(\dfrac{1}{1-\beta t}\right)^{\alpha} \text { for } t<1 / \beta\end{array} \end{equation} $$条件期望

条件分布列

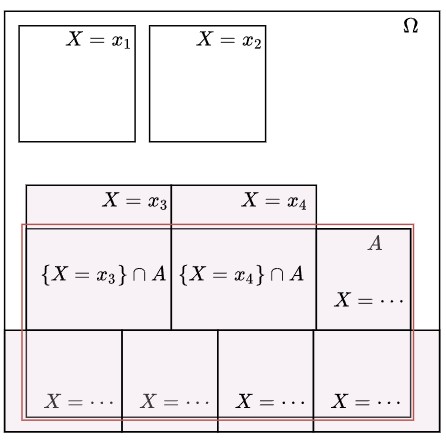

在某个事件 $A$ 发生的前提下,随机变量 $X$ 的条件分布列定义为:

$$ p_{X \mid A}(x)=\mathrm{P}(X=x \mid A)=\dfrac{\mathrm{P}(\{X=x\} \cap A)}{\mathrm{P}(A)} \text {. } $$注意, 对于不同的 $ x$, 每个都将对应一个 $\{X=x\} \cap A $,这些 $\{X=x\} \cap A $ 是互不相容的事件, 它们的并为 $ A $. 因此

$$ \mathrm{P}(A)=\sum_{x} \mathrm{P}(\{X=x\} \cap A) . $$

比较得到的两个式子, 可以看出

$$ \sum_{x} p_{X \mid A}(x)=1, $$故 $ p_{X \mid A} $ 符合分布列的要求.

条件随机变量

设某一个试验中有两个随机变量 $ X $ 和 $ Y $. 我们假定随机变量 $ Y $ 已经取定一个值 $ y $ ( $ \left.p_{Y}(y)>0\right) $, 这个 $ y $ 值提供了关于 $ X $ 取值的部分信息. 这些信息包含于 $ X $ 的给定 $ Y $ 的值的条件分布列 $ p_{X \mid Y} $ 中. 所谓条件分布列就是 $ p_{X \mid A} $, 其中事件 $ A $ 就是事件 $ \{Y=y\} $;

$$ p_{X \mid Y}(x \mid y)=\mathrm{P}(X=x \mid Y=y) . $$利用条件概率的定义, 我们有

$$ p_{X \mid Y}(x \mid y)=\dfrac{\mathrm{P}(X=x, Y=y)}{\mathrm{P}(Y=y)}=\dfrac{p_{X, Y}(x, y)}{p_{Y}(y)} . $$现在我们固定 $ y $ 的值 $ \left(p_{Y}(y)>0\right) $, 考察 $ x $ 的函数 $ p_{X \mid Y}(x \mid y) $. 这个函数符合 $ X $ 的分 布列的要求: 对每个 $ x, p_{X \mid Y}(x \mid y) \geq 0 $, 并且将这些值累加后得1. 另外, 作为 $ x $ 的函 数, 其形状与 $ p_{X, Y}(x, y) $ 相似. 两者相差一个因子 $ p_{Y}(y) $, 这个因子使得 $ p_{X \mid Y}(x \mid y) $ 满足 条件

$$ \sum_{x} p_{X \mid Y}(x \mid y)=1 . $$条件期望

条件期望就是通常的期望,不过试验结果的空间由条件所限定的试验结果所组成。相应的概率和分布列都换成条件概率和条件分布列(关于条件方差的处理是完全类似的)

或者说,我们之前求期望不就是 随机变量每个取值乘以对应的概率,然后再相加吗?这里也是一样的,只不过对应的概率变成了条件概率罢了。

给定 $ Y=y $ 情况下 $ X $ 的条件期望为

$$ \mathbb{E}(X \mid Y=y)=\left\{\begin{array}{ll} \sum x f_{X \mid Y}(x \mid y) \mathrm{d}x & \text { 离散情形 } \\ \int x f_{X \mid Y}(x \mid y) \mathrm{d}x & \text { 连续情形 } \end{array}\right. $$如果 $ r(x, y) $ 为 $ x $ 和 $ y $ 的函数,则

$$ \mathbb{E}(r(X, Y) \mid Y=y)=\left\{\begin{array}{ll} \sum r(x, y) f_{X \mid Y}(x \mid y) \mathrm{d}x & \text { 离散情形 } \\ \int r(x, y) f_{X \mid Y}(x \mid y) \mathrm{d}x & \text { 连续情形 } \end{array}\right. $$注意! 条件期望与期望的区别。期望 $ \mathbb{E}(X) $ 是一个数值, 而 $ \mathbb{E}(X \mid Y=y) $ 是 $ y $ 的函数。观察 $ Y $ 之前, 并不知道 $ \mathbb{E}(X \mid Y=y) $ 的值, 所以 条件期望是一个关于 y 的随机变量 , 记为 $ \mathbb{E}(X \mid Y) $ 。也就是, $ \mathbb{E}(X \mid Y) $ 的随机变量, 当 $ Y=y $ 时, 其 值为 $ \mathbb{E}(X \mid Y=y) $ 。

迭代期望法则

考虑长度 $1$ 的木棍,对其截断(删去一段)。截断于任何一点的概率相同。问两次截断之后长度的期望是多少。

设第一次截断剩余长度 $X$ ,第二次截断剩余长度 $Y$ 。

对于第一次截断,这是一个均匀分布,$\mathbb{E}(X) = \dfrac{1}{2}$

对于第二次截断,相当于求:

在“第一次截断后长度为 $X$ 的条件下,第二次截断长度 $Y$ ”的期望

而“第一次截断后长度为 $X$ 的条件下,第二次截断长度 $Y$” 即 $\mathbb{E}(Y|X) = \dfrac{X}{2}$

$\dfrac{X}{2}$ 怎么来的:因为相当于截断一个长度为 $X$ 的棍子。相当于转换为一个均匀分布子问题。

因此 “第一次截断后长度为 $X$ 的条件下,第二次截断长度”为 $Y$ 的期望为

$\mathbb{E}(Y) = \mathbb{E}( \mathbb{E}(Y|X) ) = \mathbb{E}(\dfrac{X}{2}) = \dfrac{1}{4}$

我们推而广之:

对随机变量 $ X $ 和 $ Y $, 假设期望均存在, 则有

$$ \mathbb{E}[\mathbb{E}(Y \mid X)]=\mathbb{E}(Y), \\ \mathbb{E}[\mathbb{E}(X \mid Y)]=\mathbb{E}(X) $$更一般地, 对任意函数 $ r(x, y) $ 有

$$ \mathbb{E}[\mathbb{E}(r(X, Y) \mid X)]=\mathbb{E}(r(X, Y)) $$证明 对于第一个等式,

$$ \begin{aligned} \mathbb{E}[\mathbb{E}(Y \mid X)] &=\int \mathbb{E}(Y \mid X=x) f_{X}(x) \mathrm{d}x=\iint y f(y \mid x) \mathrm{d}y f(x) \mathrm{d}x \\ &=\iint y f(y \mid x) f(x) \mathrm{d}x \mathrm{d}y=\iint y f(x, y) \mathrm{d}x \mathrm{d}y \\ &=\mathbb{E}(Y) \end{aligned} $$♞ 令

$$ f_{X, Y}(x, y)= \begin{cases}\frac{1}{3}(x+y), & 0 \leqslant x \leqslant 1,0 \leqslant y \leqslant 2 \\ 0, & \text { else. }\end{cases} $$求 $\mathbb{V}(2 X-3 Y+8)$

解:

$\mathbb{V}(2 X-3 Y+8) = \mathbb{V}(2X - 3Y) $

令 $r(x,y) = 2x - 3y$ ,则我们需要求 $ \mathbb{V}(2X - 3Y) = \mathbb{V}(R) = \mathbb{E}(R^2) - \mathbb{E}(R)^{2}$

$$ \begin{equation} \begin{aligned} \mathbb{E}(R) &=\iint_{D} r(x, y) f_{X,Y}(x, y) \mathrm{d}y \mathrm{d}x \\ &=\iint_{D}(2 x-3 y) \dfrac{1}{3}(x+y) \mathrm{d}y \mathrm{d}x \\ &=\int_{0}^{1} \mathrm{d}x \int_{0}^{2} \dfrac{1}{3}(2 x-3 y)(x+y) \mathrm{d}y \\ &=\dfrac{1}{3} \int_{0}^{1} \mathrm{d}x \int_{0}^{2} 2 x^{2}-3 y^{2}-x y \mathrm{d}y \\ &=\dfrac{1}{3} \int_{0}^{1} \mathrm{d}x\left(2 x^{2} y-y^{3}-\dfrac{x y^{2}}{2}\right)_{y \in[0,2]} \\ &=\dfrac{1}{3} \int_{0}^{1} 4 x^{2}-2 x-8 \mathrm{d}x \\ &=\dfrac{2}{3} \int_{0}^{1} 2 x^{2}-x-4 \mathrm{d}x \\ &=\dfrac{2}{3}\left(\dfrac{2}{3} x^{3}-\dfrac{x^{2}}{2}-4 x\right) _{x \in[0,1]} \\ &=\dfrac{2}{3}\left(\dfrac{2}{3}-\dfrac{1}{2}-4\right) \\ &=\dfrac{2}{3}\left(\dfrac{4}{6}-\dfrac{3}{6}-\dfrac{24}{6}\right) \\ &=\dfrac{2}{3} \cdot\left(\dfrac{1}{6}-\dfrac{24}{6}\right) \\ &=-\dfrac{23}{9} \end{aligned} \end{equation} $$同理可计算 $\mathbb{E}(R^2)$

习题

♞1 Suppose we play a game where we start with $c$ dollars. On each play of the game you either double your money or half your money, with equal probability. What is your expected fortune after $n$ trials?

解:

划重点:What is your expected fortune after $n$ trials? 因此设随机变量 $X_i$ 表示某 $n$ 次赌博赢到的钱。

则 $\mathbb{E}(X_{i+1} \mid_{X_i = x} ) = \dfrac{1}{2}(2\mathbb{E}(X) + \dfrac{1}{2}\mathbb{E}(X)) = \dfrac{5}{4} \mathbb{E}(X)$

递推关系有了,代入初始条件 $\mathbb{E}(0) = c$ 。得到:

$$ \mathbb{E}(X_n) = \left(\frac{5}{4}\right)^n c $$♞2 Show that $\mathbb{V}(X) = 0$ if and only if there is a constant $c$ such that $\mathbb{P}(X = c) = 1$.

解:

根据方差定义和题给条件 $\mathbb{V}(X) = \mathbb{E}[(X - \mu )^2] = 0$ 。

方差等于零,意味着随机变量的等于均值的概率为 1。

具体来说 $\mathbb{V}(X) = \int (x - \mu_X)^2 dF_X(x) = 0$,而其中的 $(x - \mu_X)^2 \geq 0$,但不能使 $(x - \mu_X)^2 > 0$ ,因为这样导致 $\mathbb{V}(X) > 0$ ,因此 $P(X = \mu_X) = 1$

即几乎必然地 $X = \mathbb{E}(X)$。换言之,$X$ 不等于均值的概率为 0:

$\mathbb{P}(X - \mathbb{E}(X) \neq 0) = 0$

这并不表示严格地 $X = \mathbb{E}(X)$,因为概率为 0 的事件可以可能。

换言之,我们有:$\mathbb{P}(X = \mathbb{E}(X)) = 1$

♞3 Let $X_1, \dots, X_n \sim \text{Uniform}(0, 1)$ and let $Y_n = \max \{ X_1, \dots, X_n \}$. Find $\mathbb{E}(Y_n)$.

解:

我们要求 $\mathbb{E}(Y_n)$,考虑其定义式:

$$ \mathbb{E}(Y_n) = \int_{}^{}y f_Y(y) \mathrm{d}y $$可能会想到求解 $y$,但 $y$ 又不是个数字,哪儿那么容易!必须视作整体来求解。

为了得到 $f_Y(y) $,可以求出 $F_Y(y)$ ,然后对其求导。或者利用 $\mathbb{E}(Y) = \int_{0}^{\infty } \mathbb{P}(Y \geq x) \mathrm{d}y$ 求出 $ \mathbb{E}(Y_n) $

$Y_n$ 的累计分布函数:

$$ F_{Y_n}(y) = \mathbb{P}(Y_n \leq y) = \prod_{i=1}^n \mathbb{P}(X_i \leq y) = y^n $$-

$F_{Y_n}(y) = \mathbb{P}(Y_n \leq y)$ 这一步,是累计分布函数的性质。

-

如何求出这个概率呢?在上一章随机向量那一节讲过,独立同分布的前提下,有: $\mathbb{P}(X_1 \in A_1, \dots, X_n \in A_n) = \prod_{i=1}^n \mathbb{P}(X_i \in A_i)$

-

因此:$ \mathbb{P}(Y_n \leq y) = \mathbb{P}\left(\bigcap_{i=1}^{n}\left\{X_{i} < y \right\}\right) = \prod_{i=1}^n \mathbb{P}(X_i \leq y)$

-

而 $\mathbb{P}(X_i \leq y) = y$

-

所以 $\prod_{i=1}^n \mathbb{P}(X_i \leq y) = y^n$

所以:

$$ \begin{align} & E\left[\max \left(X_{1}, \ldots, X_{n}\right)\right] \\ &=\int_{0}^{\infty} P\left(\max \left(X_{1}, \ldots, X_{n}\right) \geq y\right) \mathrm{d} y \\ &=\int_{0}^{1}\left(1-y^{n}\right) \mathrm{d} y \\ &=\frac{n}{n+1} \end{align} $$♞4 A particle starts at the origin of the real line and moves along the line in jumps of one unit. For each jump the probability is $p$ that the particle will move one unit to the left and the probability is $1 - p$ that the particle will jump one unit to the right. Let $X_n$ be the position of the particle after $n$ units. Find $\mathbb{E}(X_n)$ and $\mathbb{V}(X_n)$. (This is known as a random walk.)

又是这种期望值递推关系的题。

$$ \begin{align} &\mathbb{E}(X_{i+1} \mid_{\mathbb{E}(X_i) = x})\\&= p(x-1) + (1-p) (x+1) \\&= px - p + x - px + 1- p \\&= 1+x-2p \end{align} $$这里 $E(X_i) = x$ 只是设出来的罢了,即设第 i 步,所在位置是 $x$ ,不要纠结为啥相等

得到递推关系:

$$ \mathbb{E}(X_{i+1}) = 1-2p + \mathbb{E}(X_i) $$初始条件 $E(X_0) = 0$,根据等差数列的通项公式 $a_n = a_0 + nd$

递推关系的解为 $\mathbb{E}(X_n) = n(1-2p)$

下面求解 $\mathbb{V}(X)$,我们发现并不好求 $\mathbb{P}(X = x)$ 。因为可以有很多种走的方式能够到达 $X = x$。

$$ \begin{align} \mathbb{V}(X) &= \mathbb{E}(X^2) - \mu ^2 \\ &= \sum_{}^{}x^2 \mathbb{P}(X=x) - \mu ^{2} \\ \end{align} $$考虑每次决策只有两种结果:向左或者向右。那么决策的结果 $Y_i$ 只有取值 $-1,1$,这和伯努利分布很像。但是伯努利分布的取值是 $0,1$ 。我们只需要简单平移缩放一下即可。因为 $([-1, 1] + 1) / 2 = [0,1]$,所以令 $(Y + 1) / 2 \sim \operatorname{Bernoulli}(1-p)$ . 于是 $E(Y_i) = 2(1 - p) - 1 = 1 - 2p$

于是 $\mathbb{E} (X_n) = E(\sum_{i=1}^{+\infty} Y_i) = \sum_{i=1}^{+\infty} E(Y_i) = \sum_{i=1}^{+\infty} 1 - 2p = n(1-2p)$

而

$$ \begin{aligned} &\mathbb{V} \left(\frac{Y i+1}{2}\right)=p(p-1) \\ &\Rightarrow \mathbb{V}(Y i)=4 p(p-1) \end{aligned} $$因而

$$ \begin{aligned} \mathbb{V}(X) &=\mathbb{V}\left(\sum_{i=1}^{n} Y_{i}\right) \\ &=\sum_{i=1}^{n} \mathbb{V}\left(Y_{i}\right) \\ &=4 n p(p-1) \end{aligned} $$从这里可以推出一个有意思的结论。

♞ 令 $X \sim N(0,1)$, 且 $Y=e^{X}$, 求 $\mathbb{E}(Y)$ 和 $\mathbb{V}(Y)$.

解:

对于标准正态分布,$\mathbb{E}(e^{Xt}) = M_X(t) = e^{\frac{t^2}{2}}$ ,所以 $\mathbb{E}(Y) = M_X(1) = e^{\frac{1}{2}}$

$\mathbb{E}(Y^2) = \mathbb{E}(e^{2X}) = M_X(2) = e^2$

从而 $\mathbb{V}(Y) = \mathbb{E}(Y^2) - \mathbb{E}(Y)^{2} = e^2 - e$

♞ 令 $X_{1}, \ldots, X_{n}$ 服从参数为 $\beta$ 的指数分布, 求 $X_{i}$ 的矩母函数, 证明 $\sum_{i=1}^{n} X_{i}$ 服 从参数为 $n, \beta$ 的伽马分布.

解:

指数分布的 MGF 为 $\dfrac{1}{1 - \beta t}$. 对于 $X' = X_1, \cdots, X_n$,他们是独立的,所以 $\mathbb{E}(e^{tX'}) = \mathbb{E}(X_1) \cdots \mathbb{E}(X_n) = (\dfrac{1}{1 - \beta t})^n$ ,这就是伽马分布的 MGF.

♞ 令 $X_{1} \ldots, X_{n} \sim N(0,1)$, 使用米尔不等式求 $\mathbb{P}\left(\left|\bar{X}_{n}\right|>t\right)$ 的界, 其中, $\bar{X_{n}}=n^{-1} \sum_{i=1}^{n} X_{i}$, 并与切比雪夫界作比较. 由中心极限定理,$P(|\bar{X_n}| > t)=P(\bar{z}\geqslant t \sqrt[]{n}) \geqslant \sqrt[]{\pi /2} \frac{1}{t \sqrt[]{n}}\exp (-t^2 n / 2) $